LocalAI 全面解析:在本地运行 ChatGPT、Stable Diffusion、语音助手的万能平台

你的聊天记录会被AI公司偷看吗?LocalAI让你彻底掌控AI隐私

你是否曾在使用ChatGPT时,担心自己的聊天内容被记录和分析?或者在使用AI绘画工具时,对上传的图片隐私感到不安?现在,一个名为LocalAI的开源项目正在改变这一局面——它让你能在自己的电脑上运行各种AI模型,完全脱离云端,数据100%留在本地。

图片来源:LocalAI

什么是LocalAI?

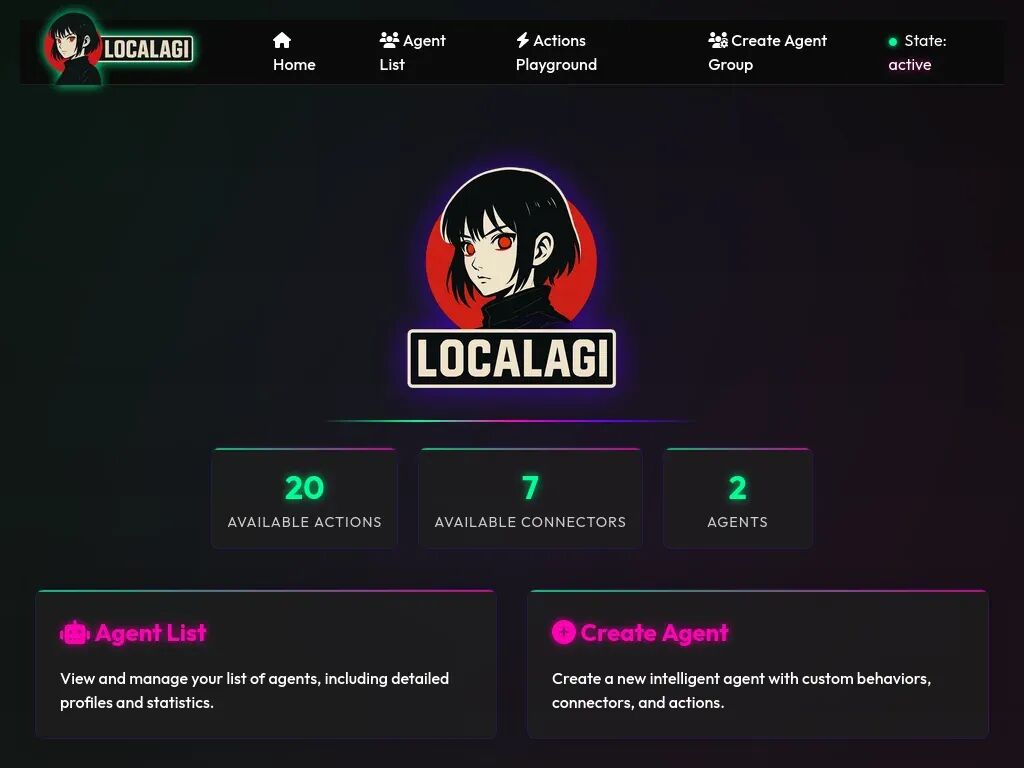

LocalAI是一个开源项目,在GitHub上已经获得超过35,000颗星,被开发者誉为”OpenAI的免费替代品”。它最大的特点是能在普通消费级硬件上运行各种AI模型,包括文本生成、图像生成、语音处理等,完全不需要连接云端服务器。

这个项目由Ettore Di Giacinto创建并维护,采用MIT开源许可证,意味着任何人都可以自由使用、修改和分发。LocalAI不仅兼容OpenAI的API接口,还支持多种模型家族和架构,包括LLMs(大语言模型)、图像生成、音频生成等。

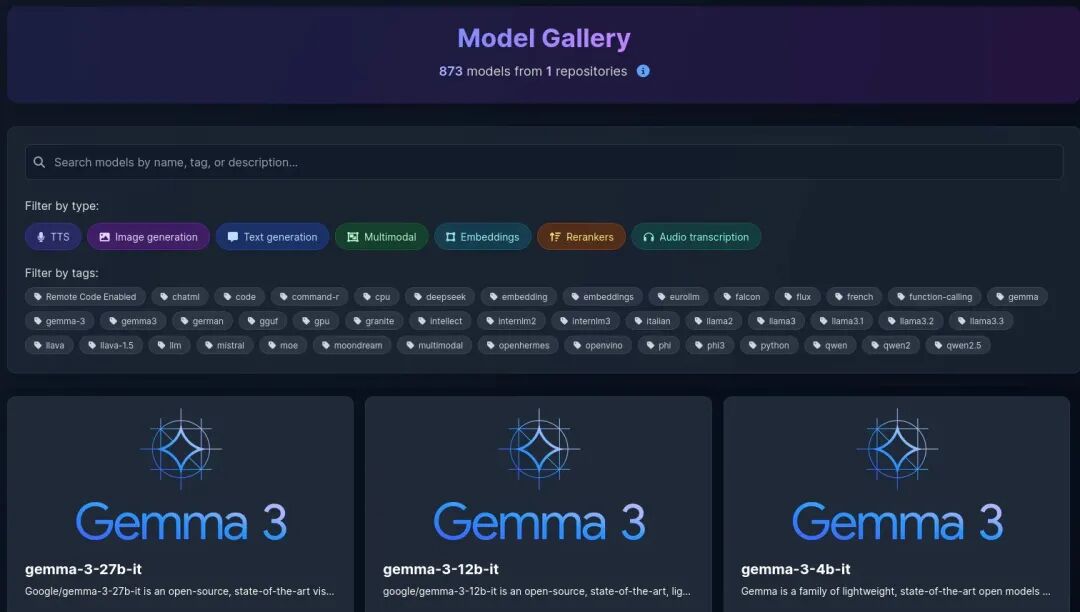

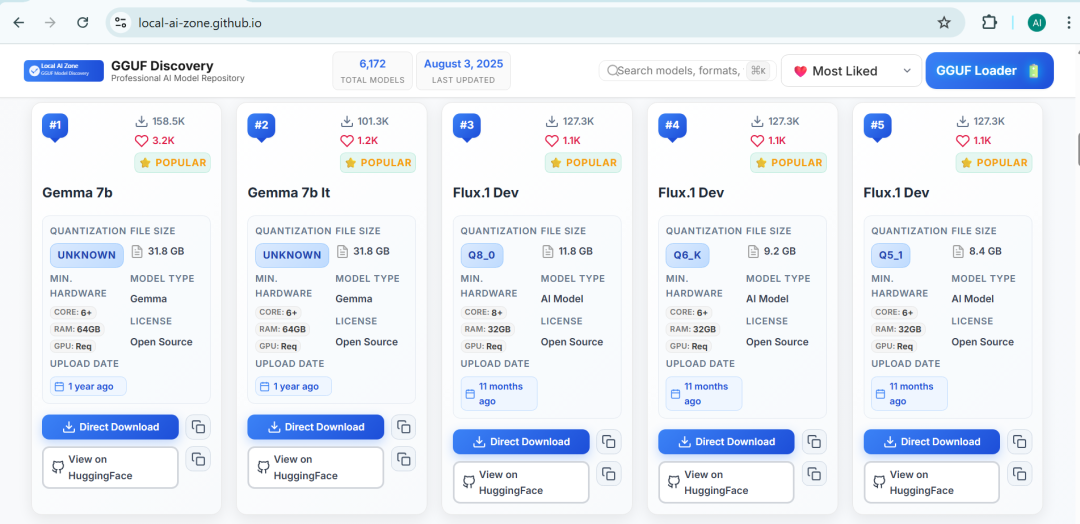

根据官方数据[1],LocalAI可以运行873种不同的AI模型,涵盖了文本、图像、音频等多个领域。这些模型可以直接从HuggingFace等平台下载,或者通过LocalAI内置的模型库获取。

为什么选择本地AI?

与云端AI服务相比,本地运行AI有三大不可替代的优势:

-

1. 隐私保护:所有数据处理都在你的设备上进行,聊天记录、生成图片等敏感信息不会上传到任何服务器。这对于企业用户和注重隐私的个人用户来说至关重要。 -

2. 成本控制:不再需要为API调用付费,一次部署后可以无限次使用。虽然初期硬件投入可能较高,但长期来看比订阅云端服务更经济。 -

3. 响应速度:无需等待网络请求往返,本地处理通常能获得更快的响应速度,特别是在处理大量数据时。

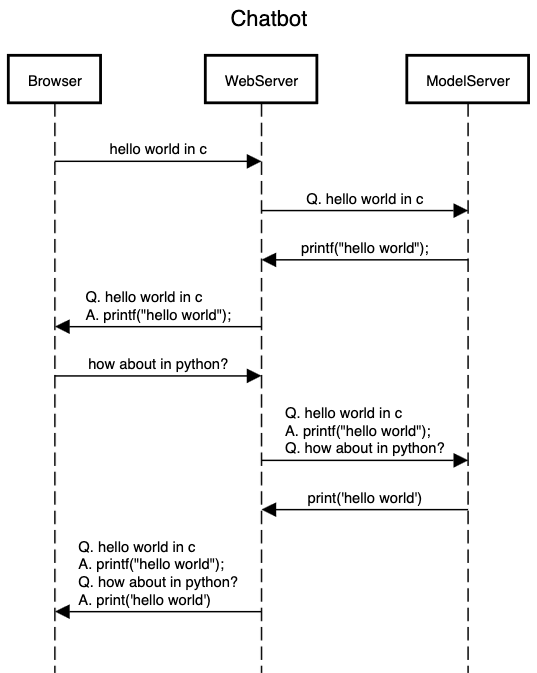

如何在本地运行ChatGPT?

LocalAI最受欢迎的功能之一就是能在本地运行类似ChatGPT的大语言模型。以下是详细部署步骤:

1. 安装LocalAI

最简单的安装方式是使用官方提供的一键安装脚本:

curl https://localai.io/install.sh | sh如果你更喜欢使用Docker,也可以选择以下命令之一:

# CPU版本

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest

# NVIDIA GPU版本(CUDA 12)

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

# AMD GPU版本

docker run -ti --name local-ai -p 8080:8080 --device=/dev/kfd --device=/dev/dri --group-add=video localai/localai:latest-gpu-hipblas2. 下载语言模型

LocalAI支持多种语言模型,包括LLaMA、GPT等。你可以直接从模型库中选择:

local-ai run llama-3.2-1b-instruct:q4_k_m或者从HuggingFace直接下载:

local-ai run huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf3. 启动并使用

安装完成后,访问http://localhost:8080就能看到LocalAI的Web界面。你可以在这里与本地运行的ChatGPT进行交互,所有对话内容都不会离开你的电脑。

Stable Diffusion本地运行指南

除了文本生成,LocalAI还能在本地运行Stable Diffusion这样的图像生成模型。以下是具体步骤:

1. 确保硬件支持

Stable Diffusion对硬件要求较高,建议至少:

-

• 8GB显存的NVIDIA GPU(如RTX 3060及以上) -

• 16GB系统内存 -

• 20GB可用存储空间

2. 安装Stable Diffusion后端

LocalAI支持多种图像生成后端,包括stablediffusion.cpp和diffusers。安装命令如下:

local-ai run stablediffusion.cpp:latest3. 下载模型权重

你可以从模型库中选择预训练的Stable Diffusion模型:

local-ai run flux.1-dev-ggml4. 生成图像

安装完成后,在Web界面中输入提示词如”a cute cat wearing sunglasses”,就能在本地生成图像,完全不需要联网。

打造本地语音助手

LocalAI还支持语音合成和语音识别功能,可以用来构建完全本地的语音助手:

1. 安装语音处理后端

LocalAI支持多种语音处理后端,包括whisper.cpp(语音识别)和bark-cpp(语音合成):

local-ai run whisper.cpp:latest

local-ai run bark-cpp:latest2. 配置语音模型

下载适合的语音模型:

local-ai run huggingface://ggerganov/whisper.cpp:base.en3. 构建语音交互系统

通过LocalAI的API,你可以:

-

• 将语音转换为文本(语音识别) -

• 将文本转换为语音(语音合成) -

• 实现语音唤醒功能(VAD)

这样就能打造一个完全本地的Siri或Alexa替代品。

常见问题与解决方案

在本地运行AI模型时,可能会遇到以下问题:

问题1:显存不足

-

• 解决方案:选择量化版本的小模型,如q4_k_m格式 -

• 示例命令: local-ai run llama-3.2-1b-instruct:q4_k_m

问题2:模型路径错误

-

• 解决方案:确保模型下载到正确的目录(通常是~/.localai/models) -

• 检查命令: local-ai models list

问题3:性能不佳

-

• 解决方案:启用GPU加速,或选择更适合你硬件的后端 -

• 根据官方文档[2],LocalAI支持NVIDIA CUDA、AMD ROCm和Intel oneAPI等多种加速技术

LocalAI的未来发展

LocalAI不仅是一个工具,更代表了一种趋势——去中心化、隐私保护的AI未来。随着项目发展,LocalAI正在增加更多功能:

-

1. 分布式推理:可以将大型模型分布在多台设备上运行 -

2. P2P网络:用户之间可以共享模型资源 -

3. 更多模型支持:持续增加对新模型架构的支持

行动起来!

现在就开始你的本地AI之旅吧!无论是为了保护隐私、节省成本,还是单纯出于技术好奇心,LocalAI都值得一试。记住,AI的未来不一定要在云端,它也可以在你的电脑里。

感谢阅读这篇关于AI语音合成突破的文章,如果觉得有趣,不妨点个赞或分享给同样热爱ai技术的朋友。

本文部分图片来源于网络,版权归原作者所有,如有疑问请联系删除。

引用链接

[1] **根据官方数据**: https://localai.io/[2] **根据官方文档**: https://localai.io/docs/overview/

© 版权声明

文章版权归原作者所有,未经允许请勿转载。

相关文章

暂无评论...