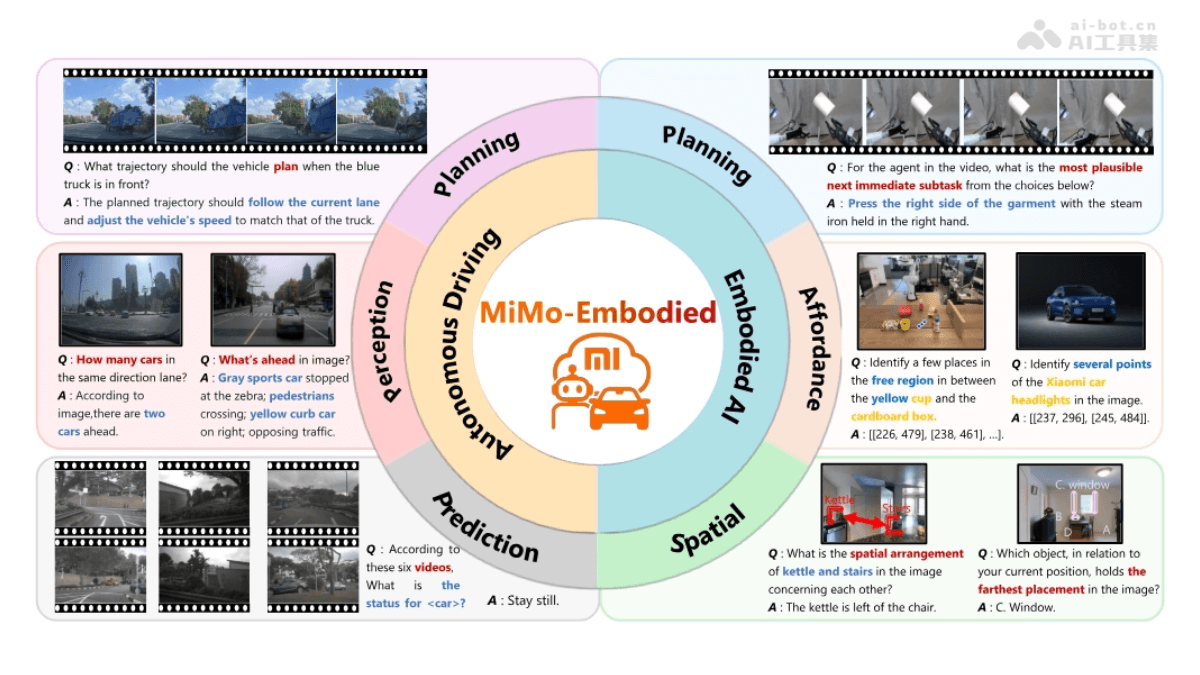

MiMo-Embodied是什么

MiMo-Embodied 是小米发布的全球首个开源的跨领域具身大模型,整合了自动驾驶和具身智能两大领域的任务,实现了在环境感知、任务规划、空间理解等多方面的卓越性能。模型基于视觉语言模型(VLM)架构,通过四阶段训练策略,包括具身智能监督微调、自动驾驶监督微调、链式推理微调和强化学习微调,显著提升了跨领域的泛化能力。在自动驾驶领域,MiMo-Embodied 能精准感知交通场景、预测动态目标行为,并生成安全高效的驾驶规划;在具身智能领域,能理解自然语言指令,完成复杂的任务规划和空间推理。MiMo-Embodied 在多项基准测试中超越了现有的开源和专用模型,展现了强大的多模态交互能力。

MiMo-Embodied的主要功能

- 跨领域整合能力:MiMo-Embodied 是首个成功整合自动驾驶与具身智能任务的模型,覆盖环境感知、任务规划、空间理解等核心能力,适用于复杂动态环境中的多模态交互。

- 环境感知:在自动驾驶场景中,模型能精准理解交通场景,包括识别交通标志、车辆、行人等关键元素,并预测其动态行为,为安全驾驶提供支持。

- 任务规划与执行:在具身智能领域,MiMo-Embodied 能根据自然语言指令生成可执行的动作序列,完成复杂的任务规划,如机器人导航与操作。

- 空间理解与推理:模型具备强大的空间推理能力,能理解物体之间的空间关系,支持导航、交互和场景理解等任务,适用于机器人操作和自动驾驶中的路径规划。

- 多模态交互:通过视觉和语言的深度融合,MiMo-Embodied 能处理图像、视频和文本输入,支持多模态任务,如视觉问答、指令遵循和场景描述。

- 强化学习优化:采用强化学习微调,提升模型在复杂场景中的决策能力和任务执行的可靠性,确保在真实环境中的高效部署。

- 开源与通用性:MiMo-Embodied 完全开源,代码和模型可在 Hugging Face 获取,为研究者和开发者提供了强大的工具,推动具身智能和自动驾驶领域的创新。

MiMo-Embodied的技术原理

- 跨领域融合架构:MiMo-Embodied 采用统一的视觉语言模型(VLM)架构,将自动驾驶和具身智能任务整合到一个模型中,通过视觉编码器、投影器和大语言模型(LLM)实现视觉输入与文本理解的深度融合。

- 多阶段训练策略:模型通过四阶段训练逐步提升性能,包括具身智能监督微调、自动驾驶监督微调、链式推理微调和强化学习微调,确保在不同任务和场景下的泛化能力。

- 视觉输入处理:利用 Vision Transformer(ViT)对单图像、多图像和视频进行编码,提取视觉特征并通过多层感知机(MLP)映射到与 LLM 对齐的潜在空间,实现视觉与语言的无缝融合。

- 数据驱动的跨领域学习:构建了涵盖通用视觉语言理解、具身智能和自动驾驶场景的多样化数据集,为模型提供丰富的多模态监督信号,支持从基础感知到复杂推理的学习。

- 强化学习优化:在训练的最后阶段,采用 Group Relative Policy Optimization(GRPO)算法进行强化学习微调,针对复杂任务和边缘场景优化模型的决策质量和可靠性。

- 推理与输出生成:通过 LLM 的推理能力,将视觉输入与语言指令结合,生成与任务相关的响应和决策,支持自动驾驶中的路径规划、具身智能中的任务执行等。

MiMo-Embodied的项目地址

- Github仓库:https://github.com/XiaomiMiMo/MiMo-Embodied

- HuggingFace模型库:https://huggingface.co/XiaomiMiMo/MiMo-Embodied-7B

- arXiv技术论文:https://arxiv.org/pdf/2511.16518

MiMo-Embodied的应用场景

- 自动驾驶:MiMo-Embodied 能处理复杂的交通场景,进行环境感知、状态预测和驾驶规划,适用于城市道路、高速公路等多种自动驾驶场景,为智能驾驶系统提供决策支持。

- 机器人导航与操作:在具身智能领域,模型可以根据自然语言指令完成室内导航、物体操作等任务,支持机器人在家庭、工业等环境中的自主行动。

- 视觉问答与交互:适用于视觉问答(VQA)任务,能理解图像或视频内容并回答相关问题,支持人机交互中的信息检索和解释。

- 场景理解与描述:模型能对复杂场景进行语义理解并生成描述,适用于安防监控、智能交通等领域的场景分析。

- 多模态任务执行:支持多模态输入,如图像、视频和文本,能处理跨模态任务,如指令遵循、图像标注等,适用于智能助手和自动化系统。

- 复杂环境中的任务规划:在复杂环境中,MiMo-Embodied 能根据指令生成多步任务规划,支持机器人完成清洁、烹饪等复杂任务。

© 版权声明

文章版权归原作者所有,未经允许请勿转载。

相关文章

暂无评论...