LongCat-Flash-Omni是什么

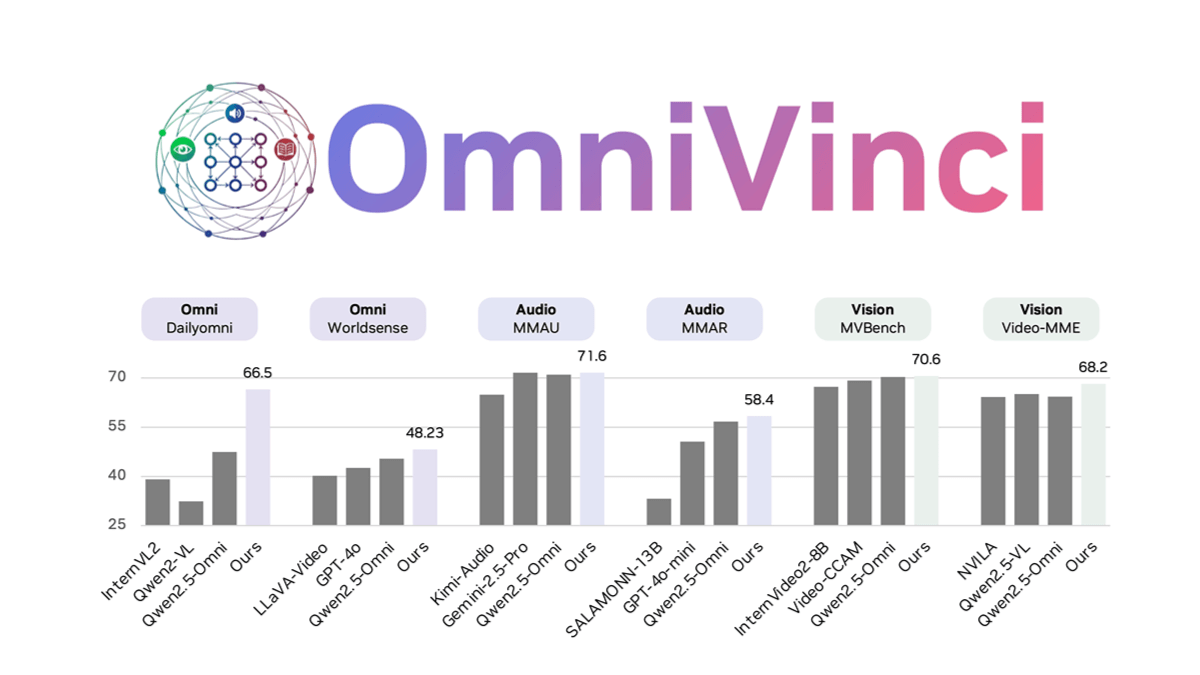

LongCat-Flash-Omni 是美团 LongCat 团队开源的全模态大语言模型,基于 LongCat-Flash 系列高效架构设计,创新性地集成多模态感知和语音重建模块,拥有 5600 亿总参数(激活参数 270 亿),实现低延迟的实时音视频交互能力。模型采用渐进式多模态融合训练策略,具备强大的文本、图像、音频、视频理解及生成能力,在全模态基准测试中达到开源最先进水平(SOTA)。模型为开发者提供高效的技术选择,推动多模态应用场景的发展。

LongCat-Flash-Omni的主要功能

- 多模态交互:支持文本、语音、图像和视频的多模态输入与输出,实现跨模态理解和生成,满足多样化交互需求。

- 实时音视频交互:具备低延迟的实时音视频交互能力,提供流畅自然的语音对话和视频理解体验,适合多轮对话场景。

- 长上下文处理:支持 128K tokens 的超长上下文窗口,能处理复杂推理任务和长文本交互,适合多轮对话和长时记忆场景。

- 端到端交互:从多模态输入到文本、语音输出的端到端处理能力,实现高效、自然的交互体验,支持连续音频特征处理。

LongCat-Flash-Omni的技术原理

- 高效架构设计:

- Shortcut-Connected MoE(ScMoE):模型采用含零计算专家的混合专家(MoE)架构,优化计算资源分配,提高了推理效率。

- 轻量级编解码器:视觉编码器和音频编解码器均为轻量级组件,参数量约 6 亿,实现性能与推理效率的最优平衡。

- 多模态融合:模型通过视觉编码器和音频编码器实现多模态输入的高效处理。通过轻量级音频解码器将生成的语音 token 重建为自然语音波形。

- 渐进式多模态训练:采用渐进式多模态融合训练策略,逐步融入文本、音频、图像和视频数据,确保全模态性能强劲且无单模态性能退化。通过平衡不同模态的数据分布,优化训练过程,提升模型的多模态融合能力。

- 低延迟交互:所有模块基于高效流式推理设计,支持实时音视频交互。通过分块式音视频特征交织机制,实现低延迟、高质量的音视频处理。

- 长上下文支持:支持 128K tokens 的上下文窗口,通过动态帧采样和分层令牌聚合策略,提升长上下文处理能力。

LongCat-Flash-Omni的项目地址

- GitHub仓库:https://github.com/meituan-longcat/LongCat-Flash-Omni

- HuggingFace模型库:https://huggingface.co/meituan-longcat/LongCat-Flash-Omni

- 技术论文:https://github.com/meituan-longcat/LongCat-Flash-Omni/blob/main/tech_report.pdf

如何使用LongCat-Flash-Omni

- 通过开源平台使用:访问 Hugging Face 或 GitHub,直接加载模型进行测试或下载代码本地部署。

- 通过官方体验平台使用:登录 LongCat 官网,体验图片、文件上传和语音通话功能。

- 通过官方 App 使用:下载官方 LongCat App,打开后即可使用联网搜索和语音通话功能。。

- 本地部署使用:根据 GitHub 文档,下载模型代码,配置本地环境,准备硬件资源(如 GPU)运行模型。

- 集成到现有系统:调用 LongCat-Flash-Omni 的 API 或集成到代码中,扩展多模态交互功能。

LongCat-Flash-Omni的应用场景

- 智能客服:通过文本、语音和图像交互,提供24/7的智能客服,实时解答问题,提升用户体验。

- 视频内容创作:自动生成视频脚本、字幕和内容,提升创作效率。

- 智能教育:提供个性化学习内容,支持语音讲解、图像展示和文本互动,满足多样化教学需求。

- 智能办公:支持语音会议记录、文档生成和图像识别,提升办公效率和协作能力。

- 智能驾驶:通过图像和视频理解实时分析路况,提供驾驶辅助。

© 版权声明

文章版权归原作者所有,未经允许请勿转载。