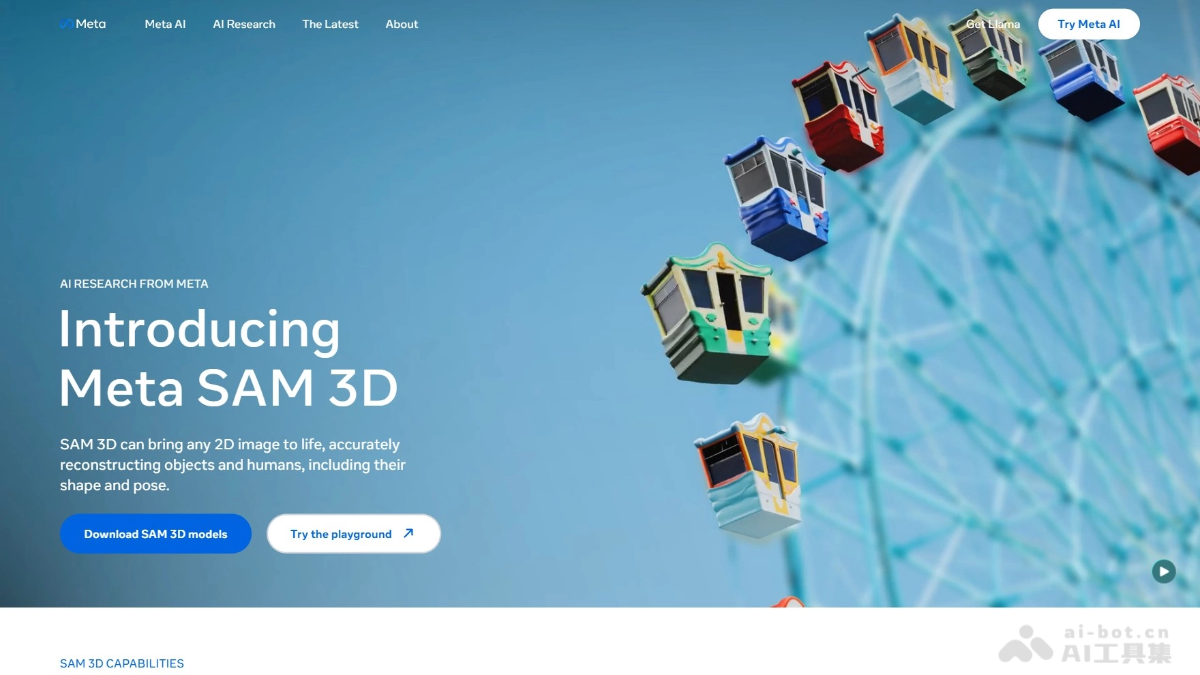

SAM 3D是什么

SAM 3D 是 Meta 推出的先进 3D 生成模型,包含 SAM 3D Objects 和 SAM 3D Body 两个子模型。SAM 3D Objects 能从单张图像重建物体和场景的 3D 模型,支持多视角一致性和复杂遮挡处理;SAM 3D Body 专注于人体姿态、骨骼和网格的高精度恢复,适用虚拟人和动作捕捉等场景。模型通过大规模数据训练和多任务学习,具备高泛化能力和鲁棒性,可应用在数字孪生、机器人感知、AR/VR 内容生成等多个领域,为 3D 视觉应用提供强大的基础能力。

SAM 3D的主要功能

- SAM 3D Objects

- 从单张图像重建 3D 物体和场景:能从单张二维图像中预测物体的三维结构,包括深度估计、网格重建、材质与表面外观估计。

- 多视角一致性:生成的 3D 模型在不同视角下保持一致,适合多视角查看和交互。

- 复杂场景处理:支持复杂遮挡、非正面视角和弱光场景下的重建,具有强大的泛化能力。

- 应用场景:适用数字孪生、机器人感知、室内外场景重建、自动驾驶环境理解等。

- SAM 3D Body

- 人体姿态与网格恢复:支持从单张图像恢复人体的三维姿态、骨骼结构和可动画网格,支持高精度的手部、脚部及肢体关键点恢复。

- 高鲁棒性:能处理非标准姿势、遮挡和部分出画的情况,适合复杂的实际场景。

- 应用场景:适用虚拟人建模、动作捕捉、数字资产制作、游戏开发等。

SAM 3D的技术原理

- 多头预测结构:SAM 3D 通过多头预测结构,同时输出深度、法线、遮罩和网格等多模态信息,提升重建的准确性和完整性,在处理复杂场景和遮挡时表现出色。

- 大规模数据训练与弱监督学习:用大规模数据引擎,结合人类标注和 AI 生成数据,SAM 3D 采用弱监督学习,减少对高质量标注的依赖,增强模型的泛化能力。

- Transformer 编码器 – 解码器架构:SAM 3D Body 用 Transformer 架构,支持基于提示的预测(如掩码和关键点),实现高精度人体姿态和网格重建,适应复杂姿势和遮挡。

- 创新数据标注引擎:通过人类标注员评估模型生成的 3D 数据,SAM 3D 的数据引擎高效标注大规模真实世界图像,弥补 3D 数据稀缺的不足。

- 优化与高效推理:SAM 3D 采用扩散模型等技术优化推理速度,实现低显存占用和快速重建,适合在常见硬件上实时运行。

SAM 3D的项目地址

- 项目官网:https://ai.meta.com/sam3d/

- GitHub仓库:

- SAM 3D Body:https://github.com/facebookresearch/sam-3d-body

- SAM 3D Objects:https://github.com/facebookresearch/sam-3d-objects

- 技术报告:https://ai.meta.com/research/publications/sam-3d-body-robust-full-body-human-mesh-recovery/

SAM 3D的应用场景

- 室内外场景重建:从单张照片重建建筑、室内布局等场景的 3D 模型,用于虚拟设计、建筑可视化和数字孪生。

- 自动驾驶环境理解:帮助自动驾驶系统快速理解复杂环境的 3D 结构,提升环境感知能力。

- 单图人体恢复:从单张照片生成高精度的人体姿态和网格,用于虚拟角色建模。

- 低成本动作捕捉:无需复杂设备,通过单张图像实现动作捕捉,适用影视、游戏等前期制作。

- 3D 模型生成:从单张图像快速生成可在 AR/VR 中自由查看的 3D 模型,提升内容创作效率。

- 虚拟场景构建:结合其他模型(如 SAM),构建逼真的虚拟场景,用于沉浸式体验。

© 版权声明

文章版权归原作者所有,未经允许请勿转载。

相关文章

暂无评论...