每次使用在线AI服务,你的数据和隐私都可能踏上未知的旅程。有没有想过,让AI的能力完全归属于你自己?

现在,这已成为现实。LocalAI 让你能在自己的电脑上运行各类AI模型——无需联网,不必付费,所有操作都在本地进行。

它就像为你量身定制的私人智能助手,安静地住在你的设备里,随时听候差遣。接下来,让我们一起了解这个开创性的项目。

简介

LocalAILocalAI是一个开源的本地AI推理框架,基于OpenAI API规范构建,允许用户在消费级硬件上本地运行大型语言模型(LLM),而无需GPU。

核心优势

彻底的数据隐私保护

与传统AI服务不同,LocalAI的所有数据处理完全在本地完成。这意味着您的敏感信息、商业机密或个人数据永远不会离开您的设备,为您提供最高级别的数据安全保障。

经济高效的解决方案

不再需要支付持续的API调用费用,也不再需要投资购买昂贵的高端GPU 。LocalAI经过优化,可以在普通的CPU环境下运行,大大降低了AI的使用门槛和成本。

离线和无网络环境使用

无论是在无网络连接的偏远地区,还是在注重网络安全的企业内网环境,LocalAI都能提供完整的AI功能支持,打破了传统AI服务对网络连接的依赖。

功能特性

文本生成

-

在本地设备上运行类似GPT的大型语言模型 -

实现智能对话、内容创作、代码生成等功能 -

支持多种模型后端,包括llama.cpp、gpt4all.cppall.cpp等主流开源引擎 -

兼容OpenAI API规范,可直接对接现有应用生态

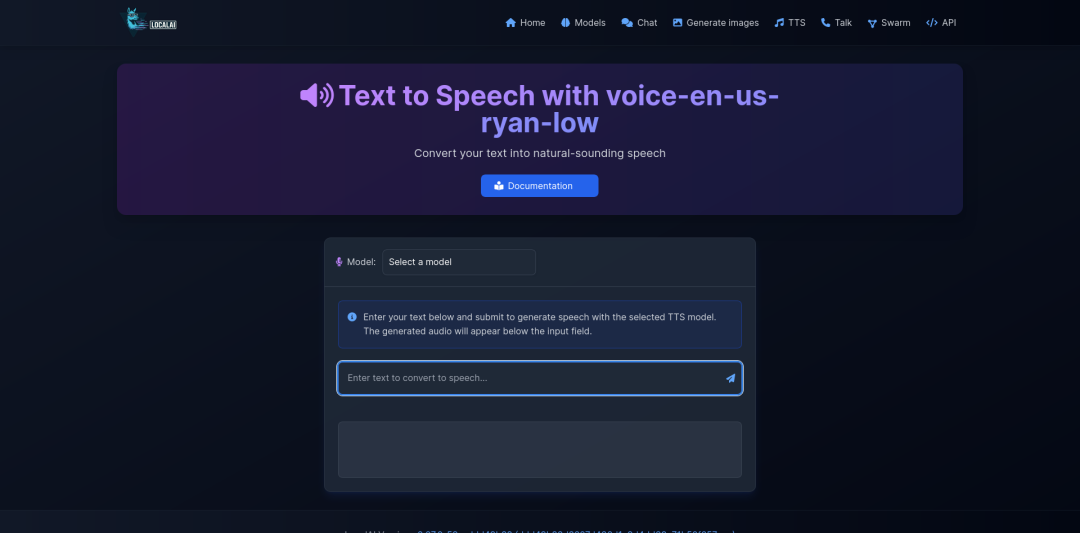

语音处理

-

提供完整的文本转语音功能,支持多种TTS模型 -

具备语音识别能力,可将音频文件转换为文本 -

基于whisper.cpp实现,支持多种语言和口音识别

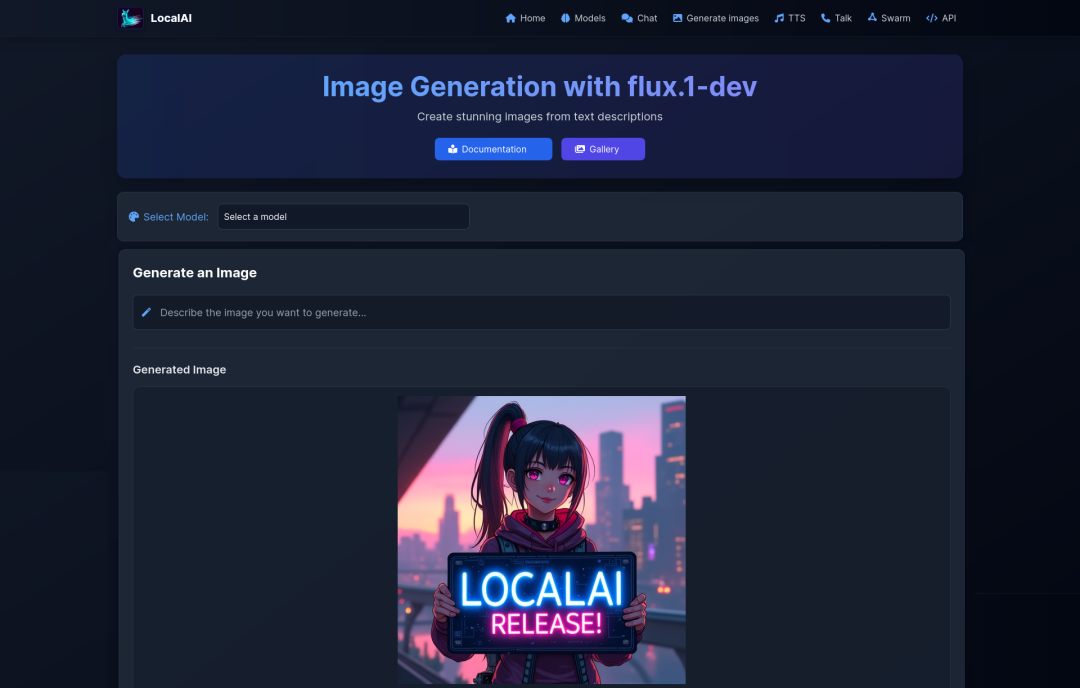

图像创作

-

集成Stable Diffusion等图像生成模型 -

在本地设备上创建高质量图像 -

通过简单的API调用即可生成图像

嵌入式模型

-

为语义搜索和分类任务提供支持 -

可用于构建个性化的推荐系统和知识库应用

多模态支持

-

统一框架支持文本、图像、音频等多种AI任务 -

能够在同一个平台上处理不同类型的AI需求

硬件兼容性

-

支持在纯CPU环境中运行,无需高端GPU -

可选GPU加速,提升推理速度和性能 -

适配消费级硬件,大幅降低使用门槛

快速部署

使用Docker部署LocalAI非常简单,只需一条命令即可:

sudo docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu

对于拥有NVIDIA显卡的用户,可以使用支持GPU的镜像:

sudo docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

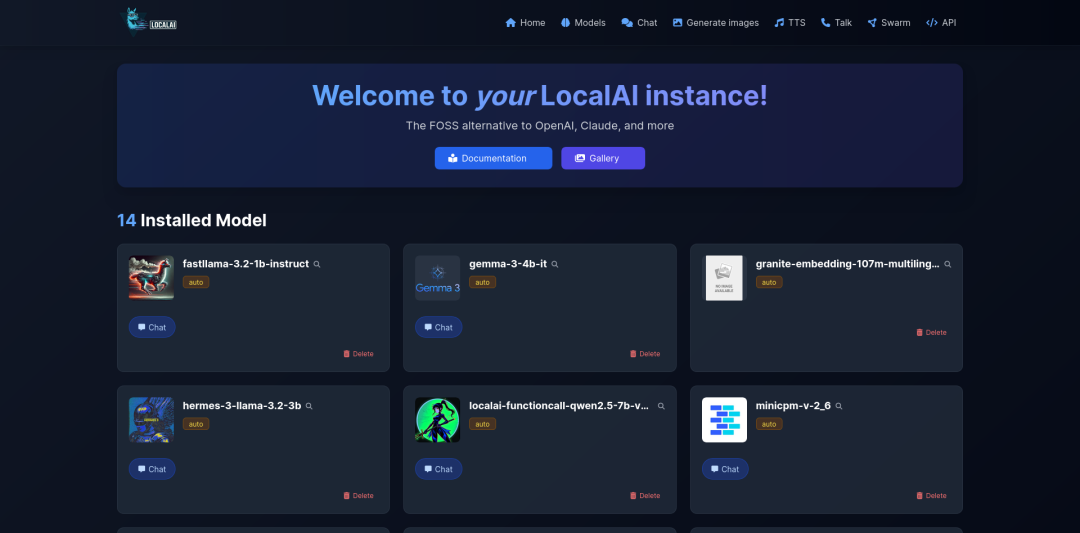

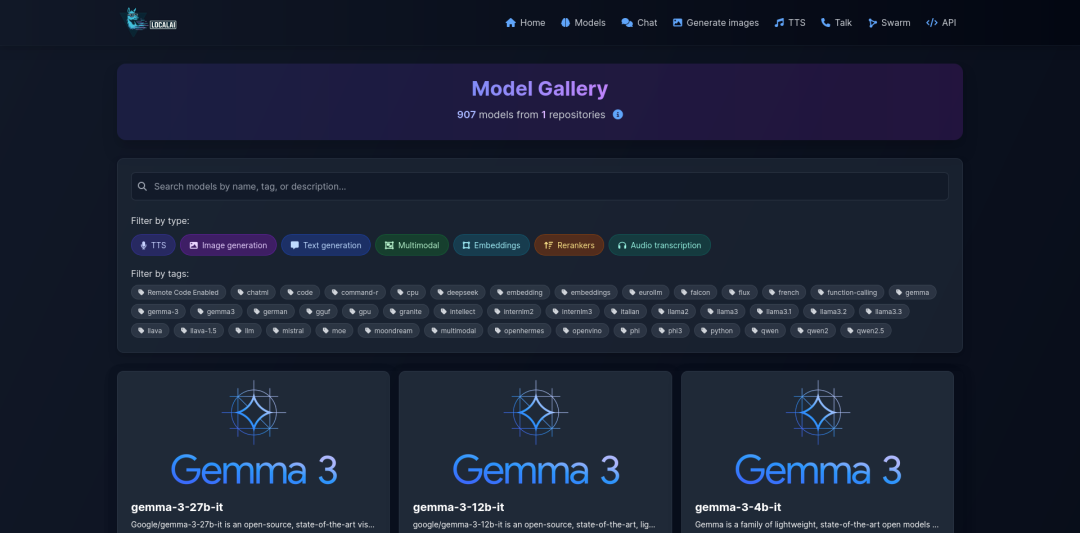

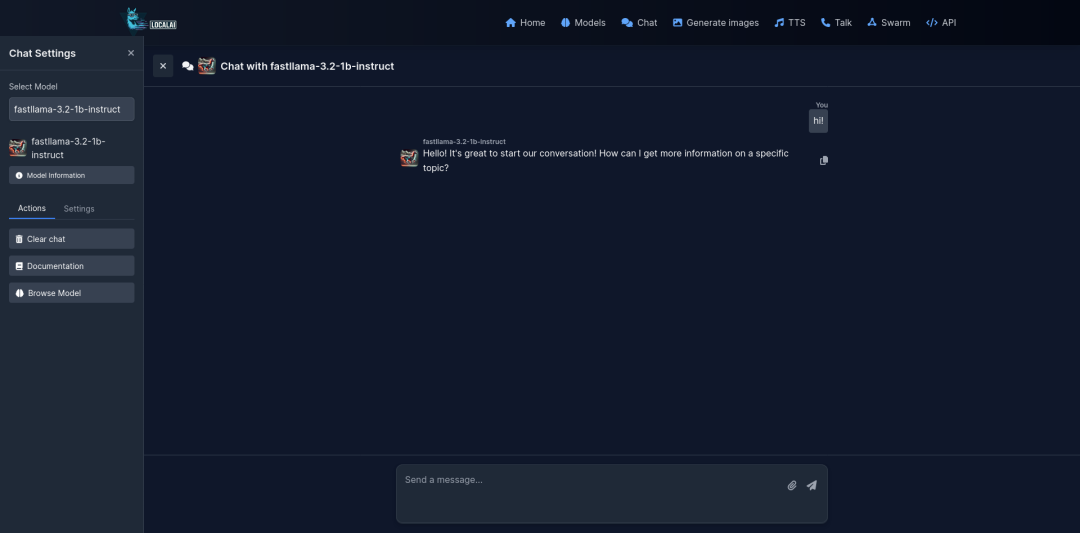

界面预览

主页

通话接口

模型概述

聊天界面

登录

开源地址

https://github.com/mudler/LocalAI

构建高质量的技术交流社群,欢迎从事编程开发、技术招聘HR进群,也欢迎大家分享自己公司的内推信息,相互帮助,一起进步!

文明发言,以

交流技术、职位内推、行业探讨为主

© 版权声明

文章版权归原作者所有,未经允许请勿转载。

相关文章

暂无评论...