打造过上亿用户规模的产品,聚集于AI应用的实践落地。

|

|

|

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

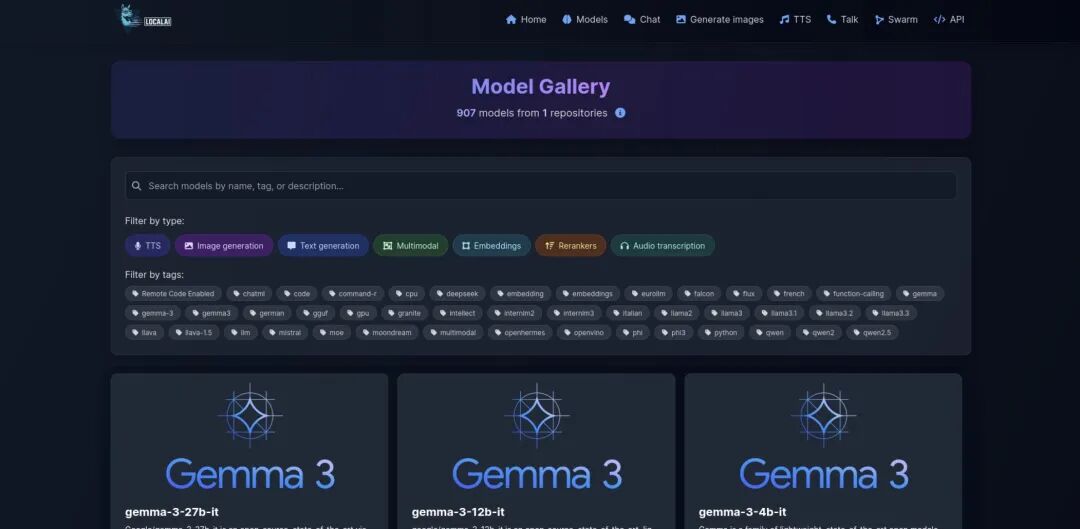

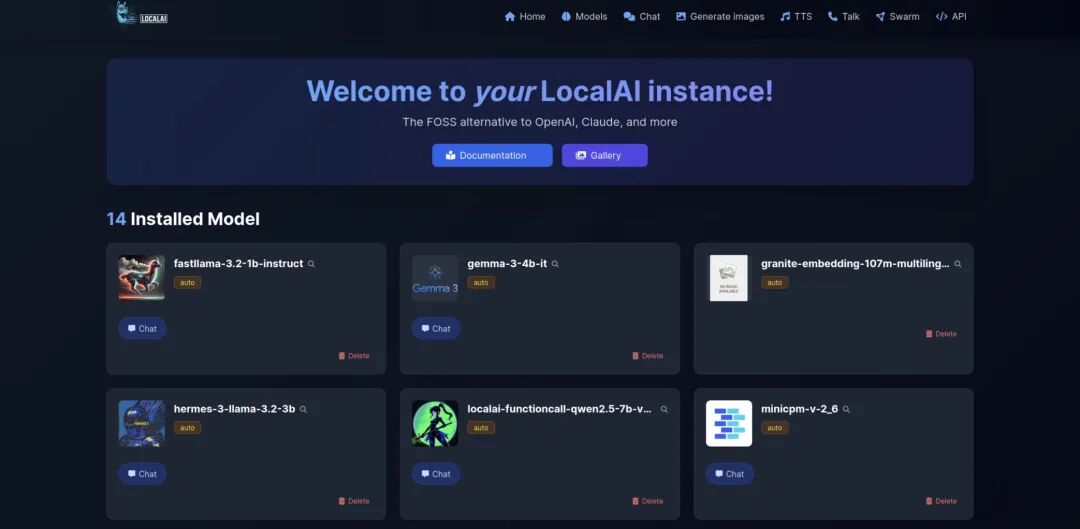

简单说,LocalAI 是一个 “本地版 OpenAI”。它能模拟 OpenAI 的 API 接口,让我们在自己的电脑、服务器甚至边缘设备上运行 AI 模型,而不用把数据传到云端。

它解决的核心痛点,其实也是我们用 AI 时最头疼的问题:

- 隐私焦虑

用 ChatGPT 这类云服务时,输入的敏感数据(比如公司文档、个人信息)会被上传,存在泄露风险。LocalAI 让数据全程在本地处理,从根源上避免了这个问题。 - 成本高昂

云服务按调用次数收费,长期使用成本不低;而 LocalAI 一次部署,后续使用几乎零成本。 - 依赖网络

没有网络时,云 AI 完全用不了。LocalAI 离线就能运行,适合网络不稳定的场景。 - 硬件门槛

很多人觉得跑大模型必须买高端 GPU,LocalAI 却能在普通 CPU 上运行轻量化模型,大大降低了入门成本。

功能亮点:不止是 “本地运行” 这么简单

LocalAI 的功能远比 “能跑模型” 更丰富,它更像一个 “本地 AI 生态平台”:

-

OpenAI 无缝兼容:它的 API 接口和 OpenAI 完全一致。这意味着我们平时用的基于 OpenAI 的代码、工具(比如 LangChain、Flowise),几乎不用修改就能直接对接 LocalAI—— 迁移成本几乎为零。

-

多模态全能:不只是文本生成,它还支持图像生成(如 Stable Diffusion)、语音转文字(基于 whisper.cpp)、图像理解(如 LLaVA),甚至能做目标检测(最新支持 rf-detr 模型)。

-

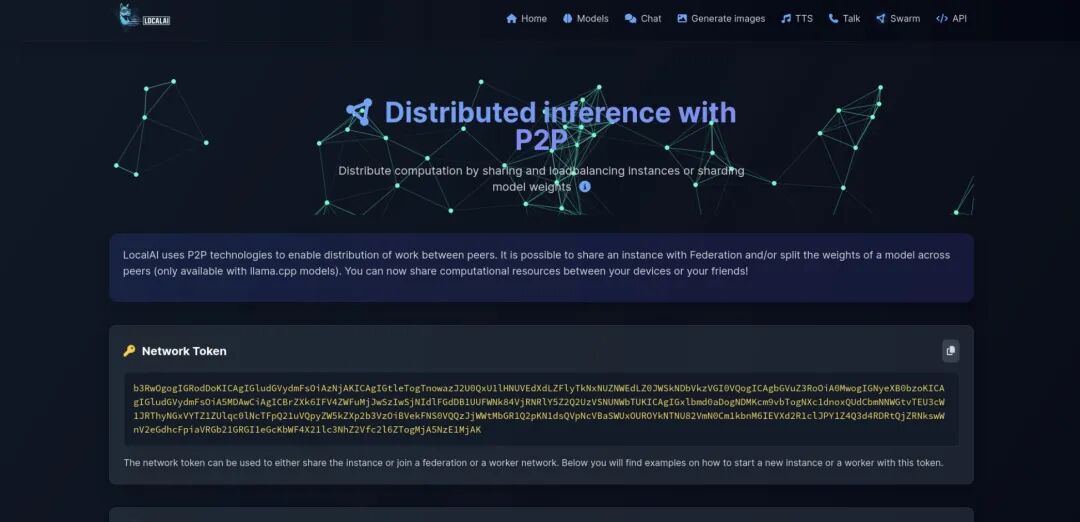

P2P 分布式推理:这是个很酷的功能:多台设备可以组成 “AI 集群”,共同分担模型运行压力。比如一台笔记本算力不够,可联合家里的其他设备一起处理,特别适合边缘计算场景。

-

模型自由切换:支持从 Hugging Face 直接下载模型,兼容 llama.cpp、vllm、diffusers 等多种后端框架。想换模型?改个配置文件就行,不用重新部署整个系统。

-

轻量易部署:提供 Docker 镜像、二进制包等多种部署方式,甚至有 “一键安装脚本”,新手也能快速上手。

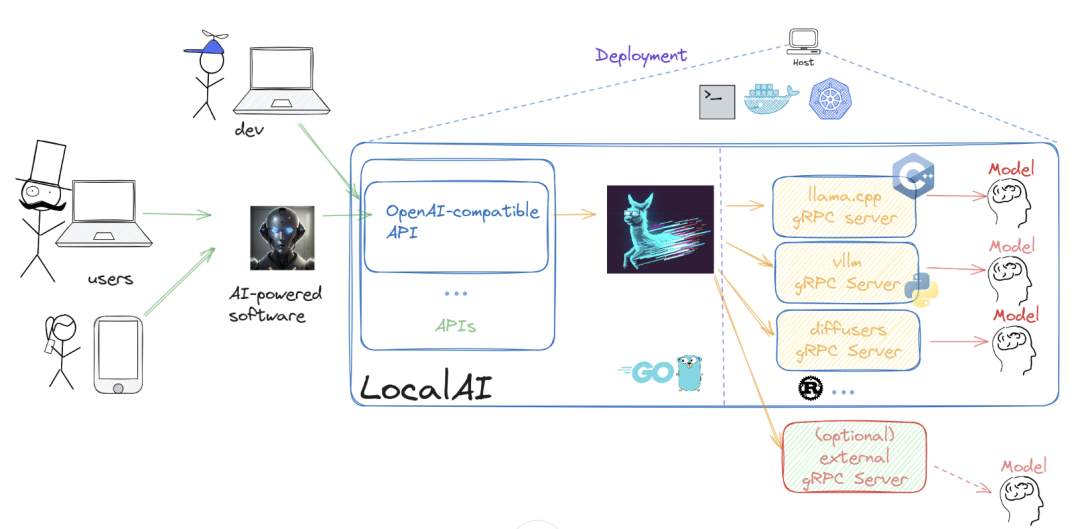

技术架构:LocalAI 是如何 “炼” 成的?

要理解 LocalAI 的架构,我们可以从 “它为什么能做到又轻量又灵活” 这个问题入手。

架构核心思路:“Go 做骨架,C++ 做肌肉”

LocalAI 的核心是用 Go 语言写的 API 服务,但它并没有重复造轮子 —— 而是巧妙地整合了社区中成熟的 C++ 项目(比如 llama.cpp、whisper.cpp)。这种设计有两个关键优势:

-

Go 语言擅长写后端 API,轻量、易维护,能高效处理网络请求; -

C++ 项目(如 llama.cpp)在 AI 推理性能上经过了大量优化,避免了 Go 语言在高频计算场景下的 GC(垃圾回收)性能损耗。

三层架构拆解

-

API 层(Go 实现)这是用户直接接触的部分,负责接收请求(比如聊天、图像生成),解析参数,并转发给对应的后端。它完全模拟 OpenAI 的 API 格式,确保兼容性。

-

后端层(多语言混合)这是 “算力中心”,整合了多种语言的 AI 推理框架:

-

C++:llama.cpp(LLM 推理)、whisper.cpp(语音处理)、stablediffusion.cpp(图像生成); -

Python:部分模型依赖 diffusers、transformers 等库; -

Go:部分轻量推理逻辑直接用 Go 实现。这些后端通过 gRPC 与 API 层通信,实现了 “按需加载”—— 用哪个模型就启动哪个后端,不浪费资源。 -

模型层存储各种预训练模型文件,支持从 Hugging Face 自动下载,也能手动导入本地模型。模型配置文件(如 .yaml)定义了模型的参数、使用的后端等信息,让切换模型变得简单。

|

|

|

|

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

应用场景:哪些地方能用上 LocalAI?

下面根据我自己的经验和对这个项目的研究,总结了以下几个应用场景:

-

企业内部知识库问答把公司文档导入系统,用 LocalAI 做本地问答,避免敏感信息泄露。比如客服团队可以快速查询内部手册,不用登录外部 AI 工具。

-

边缘设备 AI 应用在 Jetson Nano 这类边缘设备上部署,实现本地图像识别(如工厂质检)、语音控制(如智能家居),延迟更低,更可靠。

-

开源项目集成开发者可以在自己的开源工具中集成 LocalAI,提供 “离线 AI 功能”。比如代码编辑器插件、本地笔记软件的 AI 总结功能。

-

教学与研究学生和研究者可以用它低成本体验大模型运行原理,测试不同模型的效果,不用申请云服务额度。

优缺点分析:理性看待 LocalAI

优点:

- 隐私绝对可控

数据不离开本地,适合处理敏感信息; - 零成本试用

开源免费,硬件门槛低,普通电脑就能跑; - 高度兼容

无缝对接 OpenAI 生态,学习和迁移成本低; - 社区活跃

更新频繁,新模型支持快,问题解决及时。

缺点:

- 性能上限有限

CPU 运行大模型时,速度比云端 GPU 慢; - 配置有门槛

虽然有一键安装,但复杂场景(如 P2P 集群)需要一定技术储备; - 模型依赖社区

部分新模型的适配可能滞后于云服务。

本地部署教程:5 分钟跑起你的第一个本地 AI

这里以 Docker 部署为例,最简单快捷:

- 安装 Docker确保电脑已安装 Docker(Windows/Mac/Linux 均可),没安装的可以参考 Docker 官方教程。

- 启动 LocalAI

打开终端,运行以下命令(CPU 版,适合新手):

docker run -p 8080:8080 --name local-ai -ti localai/localai:latest-aio-cpu第一次运行会自动下载镜像和基础模型,耐心等待几分钟。

3. 测试 API

用 curl 发送请求(或在浏览器访问):

curl http://localhost:8080/v1/chat/completions -H "Content-Type: application/json" -d '{"model": "phi-2","messages": [{"role": "user", "content": "介绍一下你自己"}]}'

总结:LocalAI 让 AI 回归 “工具本质”

LocalAI 最打动我的,是它让 AI 从 “云端服务” 变回了 “本地工具”—— 就像我们电脑里的浏览器、编辑器一样,完全由自己掌控。

对于开发者,它是一个灵活的 AI 基础设施,能快速集成到各种项目;对于企业,它是隐私合规的低成本选择;对于普通用户,它让 “用 AI 不需要懂技术” 成为可能。

如果你也想摆脱对云 AI 的依赖,或者想探索本地大模型的可能性,不妨试试 LocalAI—— 毕竟,开源的魅力就在于 “亲手创造” 的自由。

好啦,今天的分享就到这,如果你有好的建议,欢迎留言区交流反馈~

关于架构专栏

© 版权声明

文章版权归原作者所有,未经允许请勿转载。

相关文章

暂无评论...